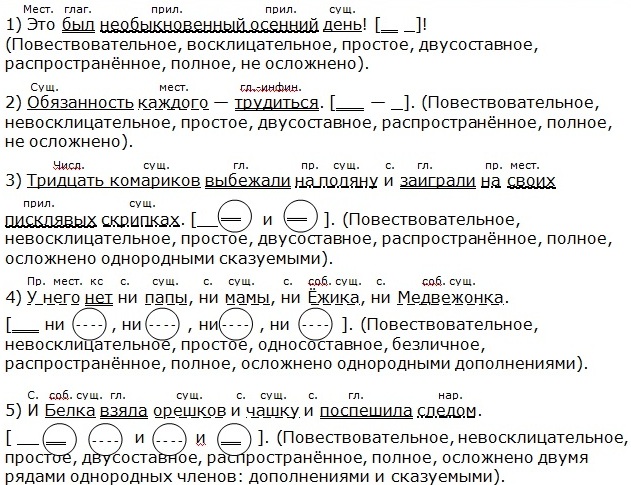

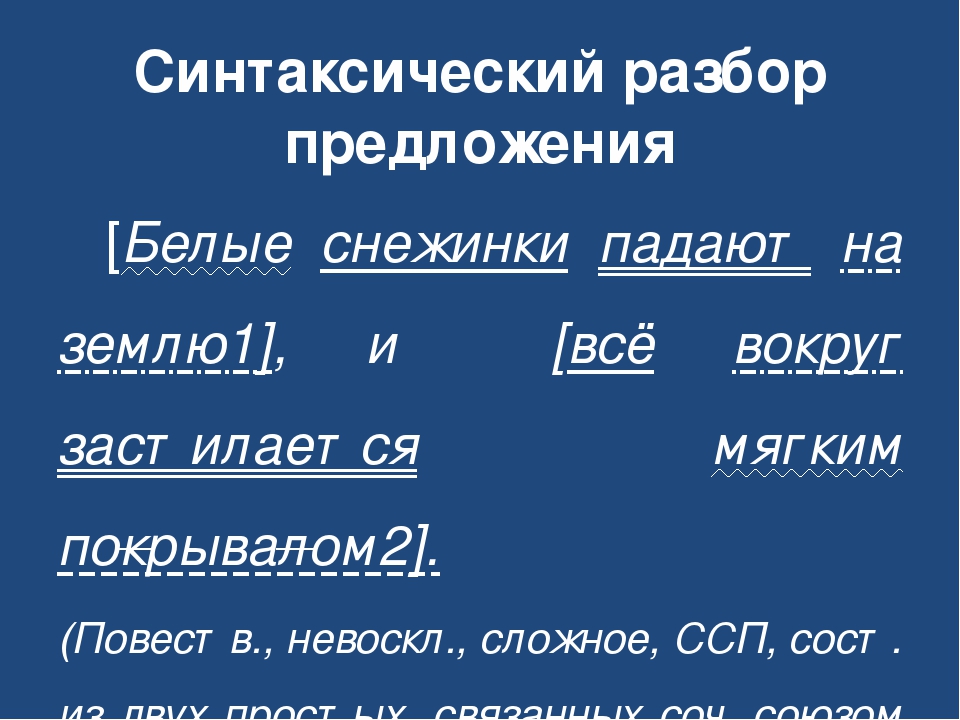

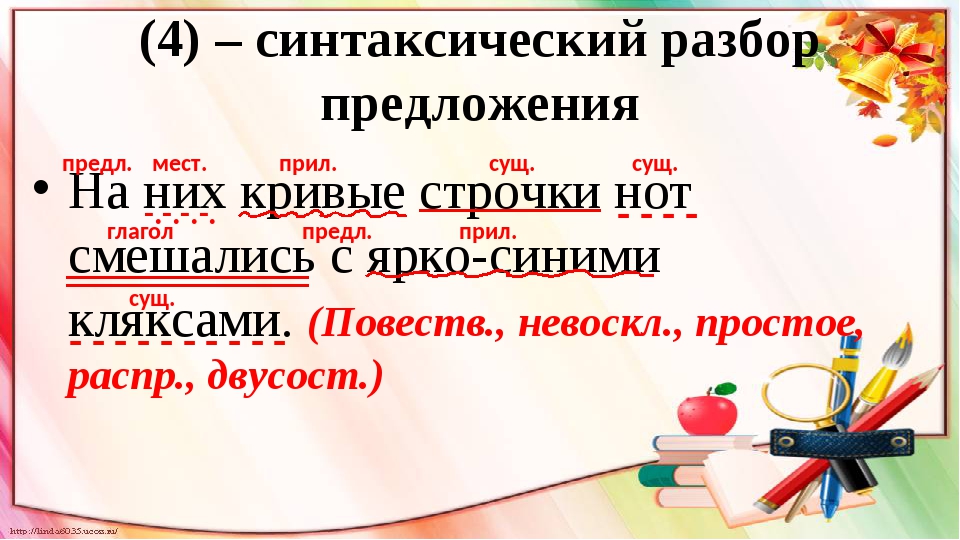

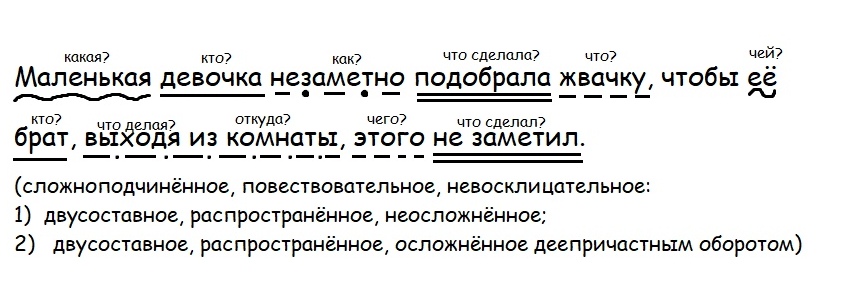

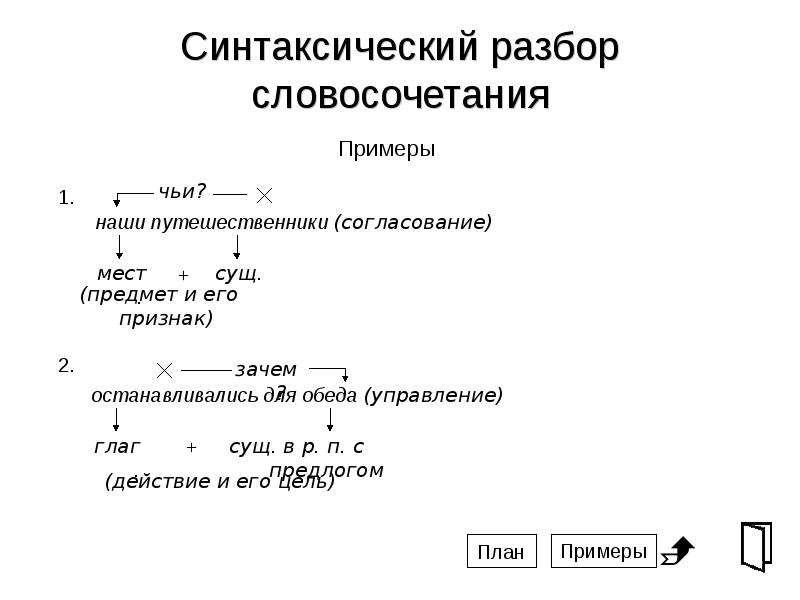

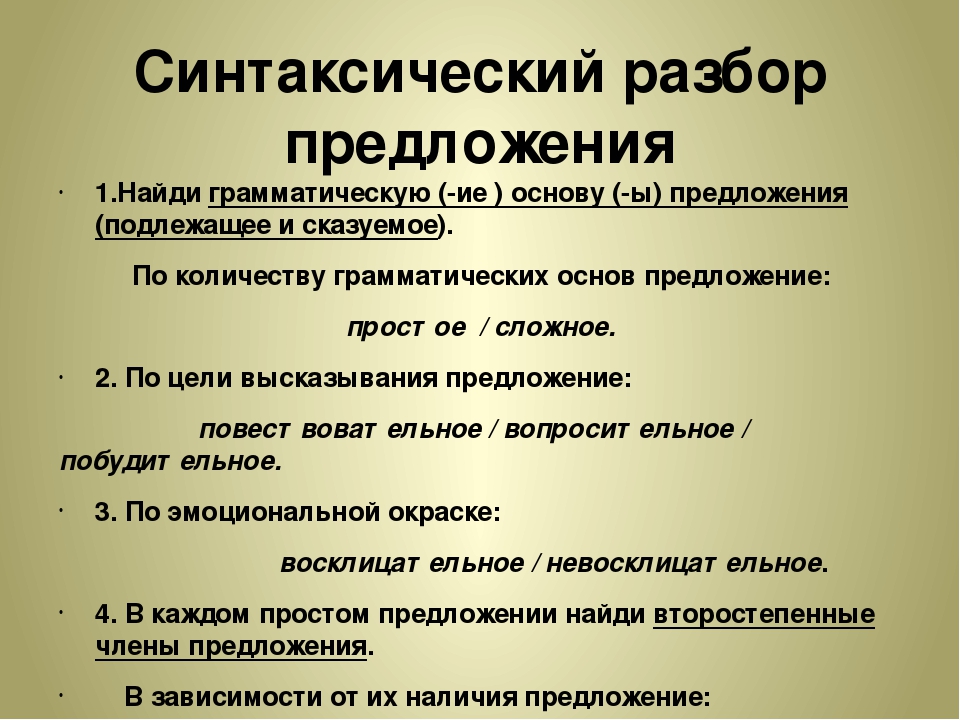

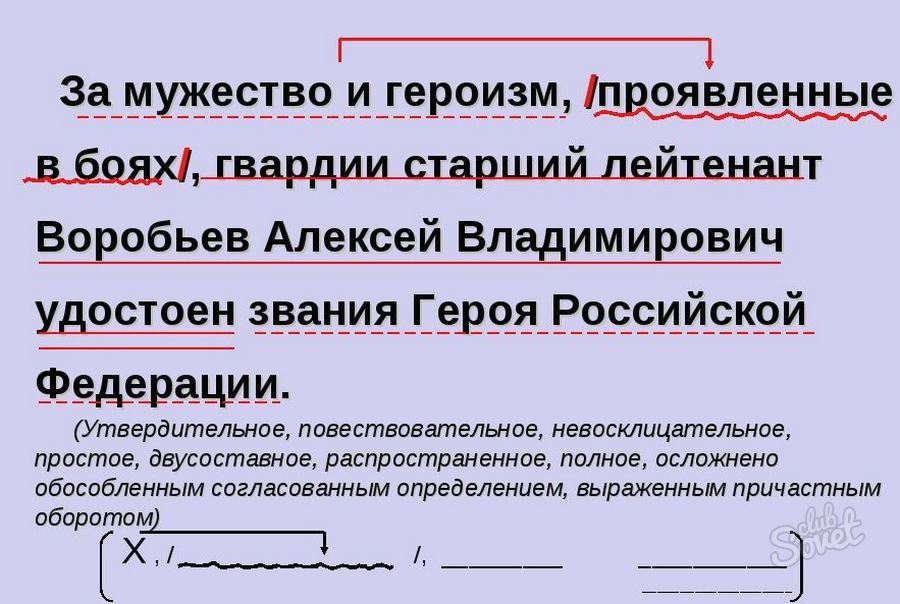

выполнеть синтаксический разбор предложения.самое главное средство увеличения числа слов в

Надо найти главные члены правления.помтгите пожалуйста.

Расскажите пожалуйста как можно больше о спряжении глагола

3. Запиши по 2 слова:с удвоенной согласнойс непроизносимой согласной в корнес парной согласнойс непроверяемой безударной гласной в корне

морфологический разбор «весеннее» помогите

помогите пожалуйста выполнить найти наречие местоимения союз

морфологический разбор «в лесу» помогите

Придумай рассказ из 5-6 предложений , о том может ли быть на Марсе жизнь?____________________________________________________________________________

…

_______________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________________ПОМОГИТЕ ПЖ СРОЧНО!!!

Задание 1 (5 баллов).

Допишите фразу:

В слове «список» количество букв и звуков ____________ (неравное/равное).

В слове «портфель» первый звук _______

…

_____ (звонкий/глухой).

Задание 2 (5 баллов).

Напишите количество букв и звуков в словах:

яблоко — ___ букв, ___ звуков;

тетрадь — ___ букв, ___ звуков;

праздник — ___ букв, ___ звуков.

Задание 3 (5 баллов).

Найдите слово, в корне которого пропущена чередующаяся гласная. Запишите в ответ это слово, вставив пропущенную букву:

р…стительность;

лес…ница;

тр…пинка;

ябл…ко.

Ответ: _____________________.

Задание 4 (5 баллов).

Укажите строчку, в которой на месте пропуска везде пишется буква Е:

щипл…т траву, в син…м небе, лежать на полян…;

гон…т гусей, хорош…й друг, закопать в земл…;

стел…т постель, могуч…й лес, убираться в дом…;

вид…шь речку, цепк…м движением, танцевать на площад….

В ответе запишите номер строки.

Ответ: ___________________________

Задание 5 (5 баллов).

Выпишите все служебные части речи из данного предложения:

Если бы можно было сейчас позвонить, прибежать, высказать!

Ответ: ___________________________.

Задание 6 (5 баллов).

Из предложения «По утрам около этого родника всегда пробегали белые собаки» выписаны словосочетания:

пробегали по утрам;

около этого родника;

пробегали всегда;

белые собаки.

Какое словосочетание не выписано из предложения? Запишите его в ответ.

Ответ: ____________________________.

Задание 7 (5 баллов).

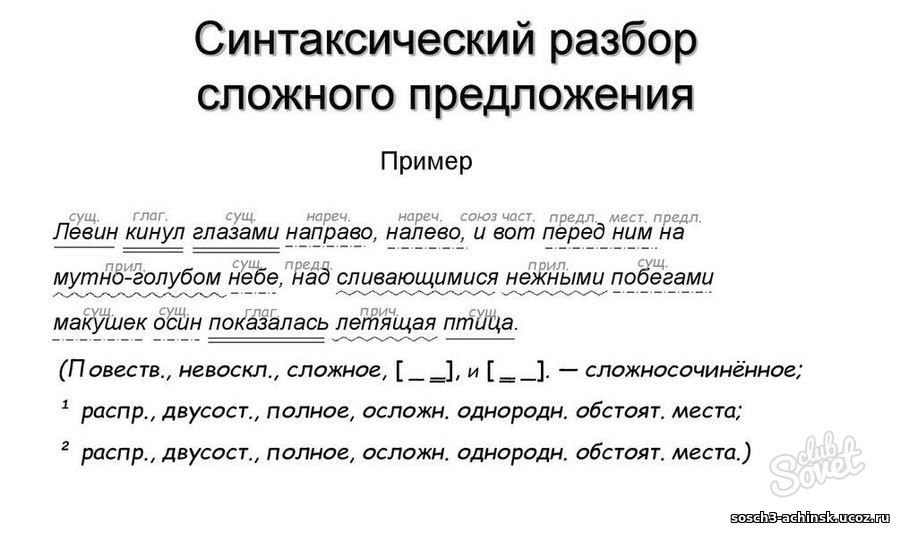

Из предложения «Рябчик весь ощетинился напрягся» выпишите грамматическую основу (запятые не расставлены).

Ответ: __________________________.

Задание 8 (5 баллов).

Выберите три верные характеристики выделенного в предложении слова и запишите в ответ их номера.

На пригорке то сыро, то жарко,

Вздохи дня есть в дыханье ночном, —

Но зарница уж теплится ярко

Голубым и зелёным огнём.

Это слово:

наречие;

изменяется;

не имеет степеней сравнения;

местоимение единственного числа;

обозначает признак действия;

в предложении является обстоятельством.

Ответ: ___________________________

Задание 9 (5 баллов).

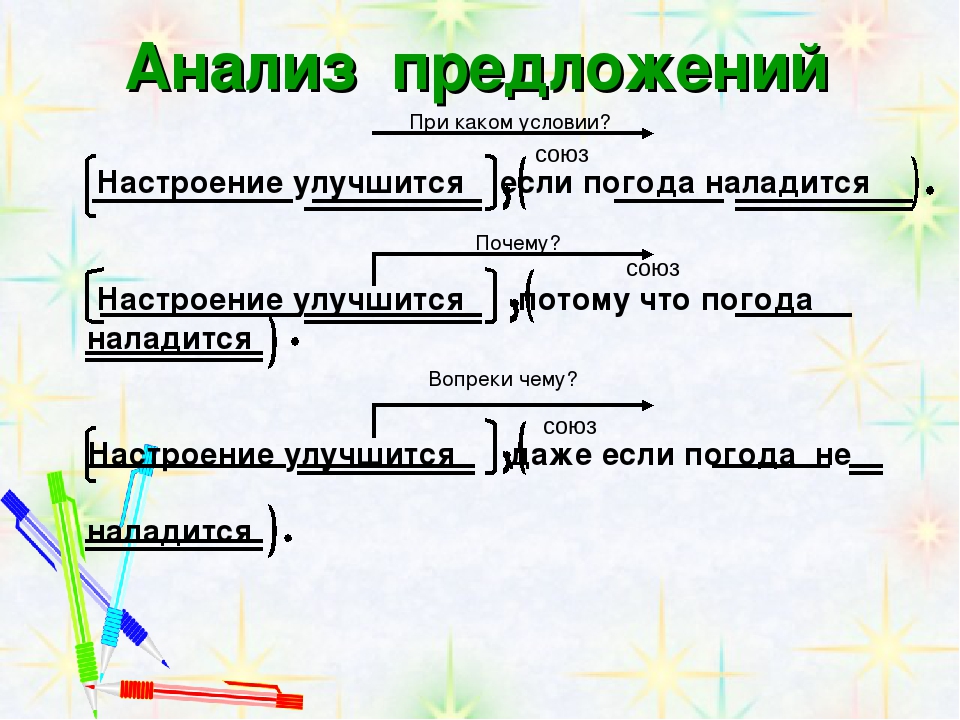

Прочитайте текст (запятые не расставлены).

(1) Мать шла позади чтобы не выпускать утят ни на минуту из виду. (2) И около кузницы при переходе через дорогу она пустила их вперёд. (3) Вот тут их увидели ребята и зашвыряли шапками. (4) Всё время пока они ловили утят мать бегала за ними с раскрытым клювом или перелётывала в разные стороны на несколько шагов в величайшем волнении. (5) Ребята только было собрались закидать шапками мать и поймать её как утят но тут я подошёл. (М. Пришвин)

(2) И около кузницы при переходе через дорогу она пустила их вперёд. (3) Вот тут их увидели ребята и зашвыряли шапками. (4) Всё время пока они ловили утят мать бегала за ними с раскрытым клювом или перелётывала в разные стороны на несколько шагов в величайшем волнении. (5) Ребята только было собрались закидать шапками мать и поймать её как утят но тут я подошёл. (М. Пришвин)

Укажите номер(-а) сложного(-ых) предложения(-й).

Ответ: ___________________________.

Задание 10 (5 баллов).

В какой последовательности надо расположить предложения, чтобы получился текст?

А. Снег давно сбежал с полей мутными ручьями.

Б. Солнце ласково пригрело проснувшуюся землю.

В. Весна — удивительное время года.

Г. От разъезда до ближней деревни зеленеет озимая рожь, и по синему небу плывут беловатые облака.

В ответе запишите буквы в нужной последовательности.

Ответ: _____________________________.

Задание 11.

Прочитайте текст и выполните задания 1-3.

(1) Сложно представить человеческую жизнь без дружбы. (2) В дружбе часто приходится сталкиваться с испытаниями, и только преданные друзья проходят их достойно. (3) Вспомним героиню сказки Г.Х. Андерсена Герду: её друг Кай попал в беду, она отправилась на его поиски, ей пришлось преодолеть множество препятствий. (4) На её пути встречались и злые разбойники, и хитрая колдунья; ей приходилось мёрзнуть и голодать. (5) Но она смогла освободить своего друга из плена Снежной королевы.

(3) Вспомним героиню сказки Г.Х. Андерсена Герду: её друг Кай попал в беду, она отправилась на его поиски, ей пришлось преодолеть множество препятствий. (4) На её пути встречались и злые разбойники, и хитрая колдунья; ей приходилось мёрзнуть и голодать. (5) Но она смогла освободить своего друга из плена Снежной королевы.

1) Определите тип речи, использованный в предложениях 1-5 (повествование, описание, рассуждение, повествование с элементами описания). (5 баллов)

Запишите ответ: ________.

2) Какой заголовок наиболее точно отражает основную мысль текста? (5 баллов)

А. Что такое дружба?

Б. Испытания в дружбе.

В. Преданные друзья.

Г. Судьба Герды.

Ответ: ______________________

3) Среди предложений 1-5 найдите такое, которое связано с предыдущим с помощью союза и личного местоимения. В ответ запишите номер этого предложения. (5 баллов)

Ответ: ______________________.

Задание 12 (35 баллов).

Напишите небольшое сочинение (от 50 слов до 70 слов) на тему «Что такое дружба?».

Паж сделайте четверть закрываю, не успеваю

ТЕКСТ ЗАДАНИЯ1 задание. Рассмотрите иллюстрации. Выполните одно задание из 2-х предложенных тем.1. Придумайте сказку о священном дереве Байтерек, испол

Рассмотрите иллюстрации. Выполните одно задание из 2-х предложенных тем.1. Придумайте сказку о священном дереве Байтерек, испол

…

ьзуя собственные знания и опыт.Повествование ведите от 1-го лица. Объем письменной работы — 100-150 слов.2. Представьте себя на месте маленькой звездочки и напишите сказку, используя имеющиеся знанияи жизненный опыт. Повествование ведите от 1-го лица. Объем письменной работы — 100-150слов.

Создайте дневниковую запись «Как я провел лето» с элементами художественного и разговорного стилей. Используйте в своей работе предложения, выражающие

…

различные состояния человека. Правильно пишите безударные падежные окончания (объем 50-60 слов). Сроочно

современные подходы и существующие проблемы – тема научной статьи по языкознанию и литературоведению читайте бесплатно текст научно-исследовательской работы в электронной библиотеке КиберЛенинка

ревень на границах регионов, которые вполне могут понимать своих соседей.

Кроме того, необходимо избегать идеи оппозиции «испанского Испании» и «испанского Латинской Америки». В рамках проведения политики популяризации испанского языка в мире нужно избежать идеи Испании как центра испаноязычной культуры и заменить ее идеей паниспанизма.

Автор статьи отмечает увеличение количества китайских студентов, изучающих испанский язык. В период с 2001 по 2006 г. их число с 1540 человек выросло втрое, а в 2016 г. уже 15 000 студентов официально обучались испанскому языку.

Таким образом, несмотря на свой мощный потенциал, испанский язык сталкивается с рядом вызовов на пути к своему дальнейшему распространению и укреплению. Скрытая языковая политика, проводимая правительством Испании, позволяет защищать позиции официального языка государства, избегая при этом критики в свою сторону. Несомненно, поддержание языкового баланса и поддержка носителей испанского языка является необходимой задачей государства. В то же время стоит помнить о том, что в эпоху глобализации распространение языка в первую очередь зависит от того, дает ли он своим носителям больше шансов на улучшение уровня жизни. В таком случае именно сильная экономика и широкое международное влияние делают язык привлекательным для населения.

В то же время стоит помнить о том, что в эпоху глобализации распространение языка в первую очередь зависит от того, дает ли он своим носителям больше шансов на улучшение уровня жизни. В таком случае именно сильная экономика и широкое международное влияние делают язык привлекательным для населения.

Е.В. Майорова

ПРИКЛАДНОЕ ЯЗЫКОЗНАНИЕ. ПЕРЕВОД, ПЕРЕВОДОВЕДЕНИЕ

2020.04.008. СЕМИНА ТА. АНАЛИЗ ТОНАЛЬНОСТИ ТЕКСТА: СОВРЕМЕННЫЕ ПОДХОДЫ И СУЩЕСТВУЮЩИЕ ПРОБЛЕМЫ1.

SEMINA T.A. Sentiment analysis: Modern approaches and existing problems.

Аннотация. Статья посвящена обзору работ по анализу тональности, одному из актуальных направлений автоматической

1 © Семина Т.А., 2020

обработки естественного языка. В настоящее время можно говорить об анализе тональности как об отдельном направлении компьютерной лингвистики. Приводятся основные термины, связанные с данной теорией, дается краткое описание возникновения анализа тональности, описываются уровни проведения анализа тональности (уровень документа, предложения, аспектов, сущностей и событий) и подходы к созданию систем. В статье представлены проблемы, связанные с проведением анализа тональности, включающие в себя выявление имплицитной оценки, сарказм и иронию, вопросы дизамбигуации, монотематичности систем, ко-референтности и референции. Представлены компьютерные подходы к улучшению результатов работы программ анализа тональности, но большее внимание уделено лингвистическим подходам. Рассматриваются вопросы создания специальных лингвистических ресурсов для анализа тональности, таких как корпусы и лексиконы, кроме того, представлены теории, связанные с синтаксическими отношениями, риторической структурой текста и добавлением блока правил.

В настоящее время можно говорить об анализе тональности как об отдельном направлении компьютерной лингвистики. Приводятся основные термины, связанные с данной теорией, дается краткое описание возникновения анализа тональности, описываются уровни проведения анализа тональности (уровень документа, предложения, аспектов, сущностей и событий) и подходы к созданию систем. В статье представлены проблемы, связанные с проведением анализа тональности, включающие в себя выявление имплицитной оценки, сарказм и иронию, вопросы дизамбигуации, монотематичности систем, ко-референтности и референции. Представлены компьютерные подходы к улучшению результатов работы программ анализа тональности, но большее внимание уделено лингвистическим подходам. Рассматриваются вопросы создания специальных лингвистических ресурсов для анализа тональности, таких как корпусы и лексиконы, кроме того, представлены теории, связанные с синтаксическими отношениями, риторической структурой текста и добавлением блока правил.

Abstract. The paper is devoted to the review of scientific works on sentiment analysys, that is one of the most relevant fields of natural language processing. Nowadays sentiment analysis may be considered as a separate area of computational linguistics. The main terms related to this sphere and a brief history are given, levels of sentiment analisis (document level, sentence level, aspect level, entity and events levels) are described. The paper states the problems associated with sentiment analysis, including the identification of implicit sentiment, sarcasm and irony, issues of disambiguation, monothematic design of the systems, coreference and reference. Computational approaches to improving the performance of sentiment analysis programs are presented, but more attention is paid to linguistic ones. The issues of creating special linguistic resources for sentiment analysis, such as corpora and lexicons, are considered, in addition, theories related to syntactic relations, the rhetorical structure of the text and the addition of a rules are presented.

The paper is devoted to the review of scientific works on sentiment analysys, that is one of the most relevant fields of natural language processing. Nowadays sentiment analysis may be considered as a separate area of computational linguistics. The main terms related to this sphere and a brief history are given, levels of sentiment analisis (document level, sentence level, aspect level, entity and events levels) are described. The paper states the problems associated with sentiment analysis, including the identification of implicit sentiment, sarcasm and irony, issues of disambiguation, monothematic design of the systems, coreference and reference. Computational approaches to improving the performance of sentiment analysis programs are presented, but more attention is paid to linguistic ones. The issues of creating special linguistic resources for sentiment analysis, such as corpora and lexicons, are considered, in addition, theories related to syntactic relations, the rhetorical structure of the text and the addition of a rules are presented.

Ключевые слова: анализ тональности; извлечение мнений; субъективность; оценка; автоматическая обработка естественного языка.

Keywords: sentiment analysis; opinion mining; subjectivity; assessment; natural language processing.

Анализ тональности как направление компьютерной лингвистики берет начало в последней декаде XX в., и сейчас является одним из самых активно развивающихся видов автоматического анализа естественного языка.

Анализ тональности, несмотря на связь с теорией оценочно-сти и эмотивности, относится к группе прикладных или компьютерных задач. Цель подобного анализа состоит в автоматическом выделении в тексте тонального компонента высказывания, включающего в себя автора мнения, которого обычно называют субъектом или источником, объект, по отношению к которому выражено мнение, и тональность, представляющую собой полярность оценки [Семина, 2017].

Термин анализ тональности (англ. sentiment analysis) начал применяться начиная с 2003 г. Одной из первых работ, в которой появился данный термин, была работа Т. Насукавы и Дж. Йи [Nasukawa, Yi, 2003], где исследовалось извлечение мнений по отношению к заданному предмету. В этом же году вышла работа K. Дейва, С. Лоуренса и Д.М. Пеннока [Dave, Lawrence, Pennock, 2003], в которой авторы говорили об «извлечении мнений» (англ. opinion mining) из отзывов о товарах. Тем не менее работы по анализу тональности и извлечению мнений начались за несколько лет до того, как были установлены данные термины, раньше такой анализ был связан с понятием семантической ориентации и анализом субъективности. Одной из первых работ по анализу тональности можно считать работу Дж. Виби о выявлении точки зрения персонажей художественной литературы. Целью работы была автоматическая классификация фрагментов текстов на объективные и на фрагменты, в которых выражено мнение или эмоции одного из персонажей художественного произведения [Wiebe, 1994]. Позже объектом исследовательского интереса стала семантическая ориентация прилагательных [Hatzivassiloglou, McKeown, 1997; Hatzivassiloglou, Wiebe, 2000; Wiebe 2000]. Дж. Виби, Р. Брюс и Т. О’Хара начали тестировать применение статистических методов к анализу субъективности [Wiebe, Bruce, O’Hara, 1999].

Позже объектом исследовательского интереса стала семантическая ориентация прилагательных [Hatzivassiloglou, McKeown, 1997; Hatzivassiloglou, Wiebe, 2000; Wiebe 2000]. Дж. Виби, Р. Брюс и Т. О’Хара начали тестировать применение статистических методов к анализу субъективности [Wiebe, Bruce, O’Hara, 1999].

Анализ тональности начал активно развиваться после появления крупных сайтов с кинорецензиями и отзывами, это связано с особенностью необходимого языкового материала для анализа тональности. В упомянутой ранее работе Дж. Виби [Wiebe, 1994] исследование проводилось на художественных произведениях, но автоматический анализ текстов такого рода не представлял интереса для широкой аудитории. С развитием сети Интернет, появлением новых пользователей и сайтов стали генерироваться большие объемы текстовых данных, содержащих оценку, и, в связи с этим возникла необходимость в их обработке. Нужно отметить, что анализ тональности применяется в тех случаях, когда невозможна ручная обработка текстов человеком, что возникает при большом объеме данных. Человек способен прочитать несколько текстов и определить в них оценку и тональность, в то время как программа за это время обработает тысячи текстов, хоть и с меньшей точностью.

Человек способен прочитать несколько текстов и определить в них оценку и тональность, в то время как программа за это время обработает тысячи текстов, хоть и с меньшей точностью.

Сам термин «тональность» не полностью соответствует понятиям «мнение» и «оценка». Раньше было принято выделять субъективные и объективные фрагменты текста, но всегда следовала оговорка о неравнозначности тональности и субъективности. Термин «тональность» менялся, подстраиваясь под новый материал, который становился объектом исследования, все дальше уходя от термина «субъективность». Классической задачей анализа тональности можно назвать анализ кинорецензий и отзывов на товары, первые крупные исследования и эксперименты проводились на этом материале. Кроме того, рецензия и отзыв как жанр подразумевают наличие мнения автора по отношению к продукту, следовательно, и тональность будет представлена в каждом из них. Кинорецензии как материал для анализа тональности не имеют большой практической ценности, но они послужили отправной точкой для развития систем анализа тональности и показали их потенциальные возможности.

Развитие сети микроблогов Twitter привело к появлению большого числа работ по анализу тональности этого материала. В компьютерных науках и компьютерной лингвистике проводится немало соревнований в различных областях, которые позволяют исследовательским группам высших учебных заведений, научных лабораторий и коммерческих компаний представить свое решение отдельных прикладных задач. Многие соревнования по анализу

тональности, в том числе SentiRuEval, проходящий в России, в обучающую и тестовые выборки добавляют именно твиты. Twitter оказался очень удачным источником для проведения анализа тональности, поскольку расширил потенциальные темы текстов. В Twitter есть как собственно отзывы, так и материалы, где высказывается мнение о различных персонах, событиях или объектах, что расширило возможности применения анализа тональности, например, для выявления мнения пользователей о политиках с возможностью регулярного мониторинга изменения тональности. Подобный проект реализует Sentdex.com, где собирают большое число данных о выделенных темах (война, система здравоохранения и т.д.) и об отдельных людях, постоянно подгружаются новые данные и можно просмотреть, как менялась тональность с течением времени. Этот сайт использует не только данные Twitter, но и публикации на различных новостных порталах. Новостные статьи как материал для анализа тональности выделяются среди остальных, поскольку тональность в них крайне далека от обыденного понимания термина «мнение». Тональность в новостных статьях скорее определяется как действие, положительно или отрицательно влияющее на некоторый объект, субъектом считается агент действия, объектом — экспериенцер.

Подобный проект реализует Sentdex.com, где собирают большое число данных о выделенных темах (война, система здравоохранения и т.д.) и об отдельных людях, постоянно подгружаются новые данные и можно просмотреть, как менялась тональность с течением времени. Этот сайт использует не только данные Twitter, но и публикации на различных новостных порталах. Новостные статьи как материал для анализа тональности выделяются среди остальных, поскольку тональность в них крайне далека от обыденного понимания термина «мнение». Тональность в новостных статьях скорее определяется как действие, положительно или отрицательно влияющее на некоторый объект, субъектом считается агент действия, объектом — экспериенцер.

Как было сказано ранее, целью анализа тональности является выделение в тексте тональных компонентов, но это может проводиться на разных уровнях. Под уровнем анализа тональности понимается единица, из которой выделяется одно мнение. Можно выделить уровень документа, предложения, аспектов, сущностей и событий. Выбор уровня анализа напрямую связан с материалом исследования и с поставленной задачей.

Выбор уровня анализа напрямую связан с материалом исследования и с поставленной задачей.

Под уровнем документа понимается анализ всего текста, выделение в нем одного субъекта (обычно совпадает с автором), одного объекта и, самое главное, одной тональности. Качественный анализ на этом уровне возможен при относительно небольшом объеме текста, как, например, у твитов, или при анализе текстов с сильно выраженной тональностью, как у отзывов или рецензий. Систем, работающих на этом уровне, немало, и они имеют в основе разные подходы.

Анализ на уровне предложений подразумевает деление исходного текста на предложения и анализ каждого из них отдельно.

После чего можно представить общую тональность для всего текста, применив правила. Стоит отметить, что анализ на этом уровне не так популярен, из доступных систем он есть в пакете Vader Sentiment в библиотеке Natural Language Tool Kit для языка программирования Python.

Анализ на уровне аспектов дает больше информации об отношении пользователей не к объекту в целом, а к его «аспектам» -отдельным компонентам объекта, которые могут иметь собственную тональность. Аспекты объекта «смартфон» могут включать в себя аспекты «камера», «операционная система», «дисплей» и т.д., иными словами, к аспектам отнесут те понятия, по отношению к которым в тексте может быть выражена тональность. Для сферы кино Т. Тхет, Дж. На и К. Кху [Thet, Na, Khoo, 2010, S. 828] выделили следующие аспекты: cast, director, story, scene, music; для каждого аспекта были представлены термины, которые могут быть отнесены к каждому из аспектов. Выделение тональности по отношению к аспектам, а не к объекту в целом, является востребованной задачей в интеллектуальном анализе данных, потому что в тексте может быть выражена положительная тональность по отношению к одному аспекту, но отрицательная по отношению к другому, и для некоторых задач это является важным фактором. Анализ тональности на этом уровне осложняется необходимостью составления списка аспектов и последующего соотнесения найденной тональности и выделенных аспектов. Составление списка нередко выполняется вручную экспертами, а для последующего анализа каждому аспекту могут приписать список терминов, которые в тексте могут быть репрезентацией аспекта.

Анализ тональности на этом уровне осложняется необходимостью составления списка аспектов и последующего соотнесения найденной тональности и выделенных аспектов. Составление списка нередко выполняется вручную экспертами, а для последующего анализа каждому аспекту могут приписать список терминов, которые в тексте могут быть репрезентацией аспекта.

Анализ на уровне сущностей является более сложным подходом, для начала стоит определить, что понимается под сущностью. Как правило, сущностью являются так называемые именованные сущности (Named Entities) — слова и словосочетания, имеющие строго определенного референта. Примерами именованных сущностей являются люди, локации, геополитические организации, средства массовой информации и т.д. Появление анализа тональности на уровне сущностей можно связать как с развитием и доступностью систем выделения именованных сущностей, так и с обращением интереса исследователей к текстам новостных статей, в которых именно такого рода анализ может дать большое ко-

личество информации. Анализ на этом уровне является одним из наиболее сложных, доступных систем пока нет. Сложность определяется необходимостью выделения сущностей, дальнейшего установления тональных отношений между ними с определением полярности оценки. Анализ тональности на уровне сущностей имеет серьезное отличие от других уровней: автор текста не всегда будет субъектом всех тональностей, сущности в тексте также могут быть субъектами мнения.

Анализ на этом уровне является одним из наиболее сложных, доступных систем пока нет. Сложность определяется необходимостью выделения сущностей, дальнейшего установления тональных отношений между ними с определением полярности оценки. Анализ тональности на уровне сущностей имеет серьезное отличие от других уровней: автор текста не всегда будет субъектом всех тональностей, сущности в тексте также могут быть субъектами мнения.

Как отдельный уровень выделяется уровень событий, хотя на самом деле от анализа тональности на уровне сущностей он мало чем отличается. Более того, «событие» может быть видом именованной сущности, следовательно, и процесс выделения тональности на этом уровне практически не отличается от представленного выше.

Методы анализа тональности не претерпели серьезных изменений во время развития этого направления. Обычно в анализе тональности выделяют подходы:

— основанный на правилах, имеет в основе набор правил, написанных экспертом-лингвистом. Подход достаточно трудоемкий, и успешность применения зависит от многих факторов, в том числе материала анализа;

Подход достаточно трудоемкий, и успешность применения зависит от многих факторов, в том числе материала анализа;

— основанный на словарях, для выявления тональности использует различные тональные лексиконы. Этот подход можно назвать одним из самых простых, потому что он сводится к выявлению тональных единиц в тексте, что довольно просто при наличии лексикона, и последующего их подсчета;

— основанный на машинном обучении, наиболее широко распространен в анализе тональности. Машинное обучение — подраздел искусственного интеллекта, изучающий методы построения алгоритмов, способных к обобщению и обучению. Традиционно в машинном обучении выделяют задачи обучения с учителем, обучения без учителя и регрессии, но в анализе тональности широко используется только первый тип алгоритмов. Это связано с особенностями регрессии и неприменимостью результатов регрессионного анализа для выявления мнений (применяется только логистическая регрессия, которая на самом деле является линейным классификатором). Обучение без учителя применяется нечасто, поскольку кластеризация, т.е. объединение документов в кластеры

Обучение без учителя применяется нечасто, поскольку кластеризация, т.е. объединение документов в кластеры

на основе метрик расстояния между ними, для анализа тональности редко дает хорошие результаты;

— гибридный, позволяет использовать одновременно несколько подходов, например машинное обучение может получать в качестве признаков не слова, а количество единиц, входящих в тональные лексиконы.

Перечисленные методы являются стандартными для интеллектуального анализа текста, при машинном обучении анализ тональности сводится к обычной классификации.

Проблемы анализа тональности

Анализ тональности, как и любой вид анализа естественного языка, имеет ряд сложно решаемых проблем.

Одной из наиболее сложных проблем считается выделение имплицитной оценки. Деление мнения на имплицитное и эксплицитное типично для анализа тональности, но раньше имплицитную оценку часто опускали и не рассматривали как объект исследования из-за сложной реализации анализа. Эксплицитная оценка в тексте выражена отдельным тональным высказыванием — словом или словосочетанием, явно выражающим тональность, это делает ее доступной для автоматического анализа. Имплицитная тональность очевидна для человека, но трудно формализуема при автоматической обработке.

Деление мнения на имплицитное и эксплицитное типично для анализа тональности, но раньше имплицитную оценку часто опускали и не рассматривали как объект исследования из-за сложной реализации анализа. Эксплицитная оценка в тексте выражена отдельным тональным высказыванием — словом или словосочетанием, явно выражающим тональность, это делает ее доступной для автоматического анализа. Имплицитная тональность очевидна для человека, но трудно формализуема при автоматической обработке.

Выделение иронии и сарказма является проблемой не только анализа тональности, но и многих других систем обработки естественного языка. Системы обработки текста оперируют графемами и словоформами, и обучить их улавливать смысл ироничных высказываний возможно только в небольшой степени.

Проблемой анализа тональности можно назвать и монотема-тичность отдельных систем. При разработке итогового продукта или обучают программу на выборке текстов определенной тематики, или учитывают характеристики текстов при написании алгоритма. Система, обученная на корпусе кинорецензий, не будет показывать высокие результаты при определении тональности, например, отзывов о мобильных телефонах из-за разной лексики, свойственной этим видам текстов.

Система, обученная на корпусе кинорецензий, не будет показывать высокие результаты при определении тональности, например, отзывов о мобильных телефонах из-за разной лексики, свойственной этим видам текстов.

Анализ тональности сталкивается и с проблемами, свойственными всем видам анализа текстов, таким как необходимость дизамбигуации и разрешения референции.

Дизамбигуация или разрешение многозначности далеко не всегда становится вопросом исследования, связанным с анализом тональности, но при использовании отдельных ресурсов она будет необходима. Для тезауруса Wordnet была проведена разметка тональности для отдельных синсетов, главных элементов этого тезауруса, и проект SentiWordnet [Baccianella, Esuli, Sebastiani, 2010] теперь входит в библиотеку Natural Language Tool Kit. Необходимость проведения дизамбигуации связана с разной тональностью значений одного слова.

Сложность представляют и проблемы референции и корефе-ренции. При анализе тональности для местоимений нужно устанавливать их антецеденты для верной интерпретации оценки, и неточные результаты разрешения референции могут привести к потенциальным ошибкам в анализе тональности. Проблема коре-ференции может решаться различными способами, или при помощи графа знаний, или при помощи дополнительных правил и составленных списков кореферентных элементов. Кореференция не ведет к серьезным проблемам с выделением мнений, но установление эквивалентности единиц позволит убрать дублирующиеся тональности.

При анализе тональности для местоимений нужно устанавливать их антецеденты для верной интерпретации оценки, и неточные результаты разрешения референции могут привести к потенциальным ошибкам в анализе тональности. Проблема коре-ференции может решаться различными способами, или при помощи графа знаний, или при помощи дополнительных правил и составленных списков кореферентных элементов. Кореференция не ведет к серьезным проблемам с выделением мнений, но установление эквивалентности единиц позволит убрать дублирующиеся тональности.

Современные подходы

Анализом тональности занимаются специалисты в области компьютерных наук и лингвисты, и с каждым годом количество статей на тему извлечения мнений не снижается. Существующие подходы не меняются, но претерпевают изменения и развиваются. Все новые идеи в анализе тональности можно разделить на две группы: изменения, связанные с применением новых алгоритмов машинного обучения, и изменения, связанные с внедрением новых лингвистических теорий и созданием новых лингвистических ресурсов. Несомненно, вторая группа интересует нас больше, но нельзя не сказать и об изменении в арсенале методов машинного обучения, применяемых в сфере анализа тональности.

Несомненно, вторая группа интересует нас больше, но нельзя не сказать и об изменении в арсенале методов машинного обучения, применяемых в сфере анализа тональности.

За последние годы арсенал методов машинного обучения значительно расширился и продолжает расширяться. Если около пяти лет назад чаще всего можно было встретить работы, в которых основным был метод опорных векторов (Support Vector Machine), один из наиболее точных линейных классификаторов, то сейчас все чаще применяются различные нейронные сети: сети прямого распространения, рекуррентные и сверточные сети. Этому способствовало развитие этой отрасли, повлекшее за собой появление крупных библиотек с нейросетями, таких как TensorFlow или Keras, обе вышли в 2015 г. Кроме того, применяются другие методы компьютерного анализа текста, в том числе тематическое моделирование.

Лингвистические новые подходы носят, стоит отметить, более разнообразный характер.

Одним из них является создание новых ресурсов для анализа тональности. Типовыми ресурсами можно назвать корпусы и тональные лексиконы, конечно, созданные для различного материала. Разметка корпуса для анализа тональности нетипична, так как для различных единиц должна быть указана тональность, поэтому обычно требуется ручная разметка, тем не менее в ряде случаев удается автоматизировать этот процесс. Для сравнения рассмотрим небольшое число корпусов для английского языка в табл. 1 [Семина, 2019].

Таблица 1

Название Объем Тексты

Movie Review Dataset 2000 документов Кинорецензии

Sentiment Relevance Corpus 125 документов 3847 предложений Кинорецензии

Sanders Twitter Dataset 5387 документов Twitter

Health Care Reform Dataset 1,922 документа Twitter

Stanford Twitter Sentiment 1 200 000 документов Twitter

MPQA v 3. 0 70 документов Новостные статьи

0 70 документов Новостные статьи

Из данных, представленных в таблице, видно, что объем корпусов различается — если корпус новостных статей собран из 70 документов, то для Twitter число документов превышает миллион. Конечно, это связано и с объемом отдельного документа, и с глубиной разметки.

Другим важным лингвистическим ресурсом для анализа тональности является тональный лексикон. Тональный лексикон включает в себя тональные единицы языка, имеющие метку полярности оценки. При этом к созданию тональных лексиконов применяют разные подходы, часто они собираются автоматически. Выделяют несколько подходов к созданию тонального лексикона: ручной, основанный на словаре и основанный на корпусе текстов [Kochergina, 2015].

Тональные словари можно разделить на три вида:

1) содержащие только слова;

2) содержащие слова и полярность оценки;

3) содержащие слова, полярность и уровень оценки [Araque, Zhu, Iglesias, 2019].

Для английского языка представлено несколько тональных лексиконов, например SentiWordnet [Baccianella, Esuli, Sebastiani, 2010], LIWC [Tausczik, Pennebaker, 2010], NTU [Chen, Huang, Chen, 2018] и the Harvard inquirer [The general inquirer, 1966].

Для русского языка в свободном доступе находится РуСен-тиЛекс [Лукашевич, Левчик, 2016], кроме того, русский язык входит в пакет списков оценочных слов, собранный Й. Ченом и С. Скиеной [Chen, Skiena, 2014].

Существует и ряд нетипичных лингвистических ресурсов, созданных для анализа тональности, одним из них являются тональные фреймы. Тональный фрейм включает в себя лексическую единицу и подробную информацию, связанную с тональными отношениями между слотами фрейма, в том числе тональные отношения. Также прописывается возможное грамматическое окружение для поиска этого фрейма и установления тональных отношений. Такие ресурсы позволяют частично выделять имплицитную тональность, поскольку фрейм может содержать подробные отношения между слотами. Недостатком подхода является трудоемкость и невозможность охватить большое количество лексики и все возможные окружения.

Такие ресурсы позволяют частично выделять имплицитную тональность, поскольку фрейм может содержать подробные отношения между слотами. Недостатком подхода является трудоемкость и невозможность охватить большое количество лексики и все возможные окружения.

Работа с синтаксическим уровнем языка

Интересным и важным является внедрение синтаксической информации в анализ. Тональность относится не только к семан-

тике, как компонент значения отдельных единиц, но и к прагматике высказывания, поэтому для максимально точного выделения тональности необходимо, начиная с графематического уровня пройти все уровни языка, чтобы дойти до тональности.

Синтаксическая информация может дополнять машинное обучение, положительно влияя на качество работы системы. При подобном подходе при обучении системы синтаксические характеристики войдут в число признаков, так в машинном обучении принято называть характеристики, при помощи которых описывается объект. Могут использоваться и синтаксические отношения, что в ряде задач будет давать лучшие результаты [Адаскина, Па-ничева, Попов, 2015].

Могут использоваться и синтаксические отношения, что в ряде задач будет давать лучшие результаты [Адаскина, Па-ничева, Попов, 2015].

Другим подходом является создание тональных корпусов с синтаксической разметкой, их можно назвать тональными трибан-ками. Группа исследователей университета Стэнфорд представила корпус Stanford Sentiment Treebank, объем которого составляет 9645 предложений [Recursive deep models for semantic compositio-nality over a sentiment treebank, 2013]. Предложения в корпусе имеют метку полярности на каждой вершине, при продвижении по дереву на каждой вершине метка зависит от показателей вершин под ней. Этот корпус используется для создания систем анализа тональности для английского языка и может использоваться совместно с разными методами автоматической классификации.

Если описанные ранее подходы к привлечению синтаксической информации были связаны с одной из теорий: грамматики непосредственных составляющих или грамматики зависимостей, то в рамках автоматической обработки возможна их комбинация. Сочетая эти способы представления структуры, можно нивелировать недостатки друг друга в извлечении оценочных выражений [Effective Sentiment Analysis of Chinese Online Reviews with Syntax Tree and Linguistics Heuristics, 2013, p. 10].

Сочетая эти способы представления структуры, можно нивелировать недостатки друг друга в извлечении оценочных выражений [Effective Sentiment Analysis of Chinese Online Reviews with Syntax Tree and Linguistics Heuristics, 2013, p. 10].

Это не единственные способы внедрения синтаксической информации в анализ тональности, кроме того, подробные синтаксические данные, которые представляют грамматика непосредственных составляющих и грамматика зависимостей, не всегда необходимы. П.Д. Турни занимался проблемой синтаксических паттернов, что можно назвать простым, но эффективным подходом к решению задачи добавления синтаксической информации.

Паттерн Турни состоит из трех элементов, соответствующих словам естественного языка, третий элемент не относится к тональному паттерну и необходим для более точного выделения паттерна [Титеу, 2002, S. 418]. Позже идея получила развитие, и паттерны были дополнены синтаксическими метками Стэнфорда, что значительно облегчало их применение [Almatameh, Gamallo, 2017]. В табл. 2 метки были заменены на эквивалентные им части речи.

В табл. 2 метки были заменены на эквивалентные им части речи.

Таблица 2

Первое слово Второе слово Третье слово

прилагательное существительное любое

наречие (может быть в сравнительной или превосходной степени) прилагательное не существительное

прилагательное прилагательное не существительное

существительное прилагательное не существительное

наречие (может быть в сравнительной или превосходной степени) глагол (начальная форма, форма прошедшего времени, форма причастия прошедшего времени, герундий) любое

Паттерны, представленные в работе П.Д. Турни, и в целом подобный подход к адаптации синтаксической информации для интеллектуального анализа, несомненно, не покрывают все возможные случаи представления тональных единиц в тексте. Тем не менее они являются более простыми в создании и применении и могут оказать положительное влияние на результат работы системы.

Турни, и в целом подобный подход к адаптации синтаксической информации для интеллектуального анализа, несомненно, не покрывают все возможные случаи представления тональных единиц в тексте. Тем не менее они являются более простыми в создании и применении и могут оказать положительное влияние на результат работы системы.

Привлечение теории риторической структуры

Дискурс как уровень языка редко становится объектом машинного анализа из-за сложностей, возникающих в процессе реализации, тем не менее он может быть полезен при анализе мнений. Идея привлечения теории риторической структуры дискурса к анализу тональности не нова, работы стали появляться с 2011 г., но эта идея не получила широкого распространения.

Несмотря на разные подходы к воплощению отдельных компонентов алгоритма, основной подход встречается во всех статьях: разбиение текста на элементарные дискурсивные единицы (ЭДЕ) и дальнейшее их объединение в древовидную структуру.

Системы такого рода дают хорошие результаты с f-мерой (одна из метрик для определения качества классификации имеет значения от 0 до 1) выше 0,7 [Polarity analysis of texts using discourse structure, 2011]. Более высокий результат показала система М. Крауса и С. Файерригеля [Kraus, Feuerriegel, 2019], также основанная на первоначальном анализе дискурса в рамках теории риторической структуры. Кроме того, возможно привлечение глубоких нейросе-тевых моделей, например рекуррентных нейронных сетей [Bhatia, Ji, Eisenstein, 2015].

Риторическая структура позволяет выделить более и менее «важные» фрагменты, и в соответствии с этим корректировать тональности этих фрагментов.

Добавление списка правил

Добавление правил можно считать одним из наиболее часто встречаемых способов улучшения работы алгоритма. Правила могут покрывать различные виды задач.

Правила могут покрывать различные виды задач.

Возможно добавление правил для поиска ироничных и саркастических конструкций, которые будут основаны на поиске фрагментов текста, соответствующих некоторому шаблону. Частично это поможет решить проблему сарказма.

Часто отдельно расписывают правила для обработки отрицаний. В ряде случаев вводят правила, которые на начальном этапе работы добавляют единицам, входящим в сферу действия отрицания, определенный отрицательный маркер, например «не_хоро-ший». В таком случае компьютер будет считать это слово отдельной лексической единицей. Несомненно, существуют и другие подходы к решению этой задачи [A survey on the role of negation in sentiment analysis, 2010].

Добавление правил может также выделить часть имплицитной информации, например, Л. Чжан и Б. Лью [Zhang, Liu, 2011] собрали лингвистические шаблоны для распознавания фраз, выражающих имплицитное мнение, Л. Денг и Дж. Виби [Deng, Wiebe, 2015] использовали логические операции. Их модель определялась использованием множества элементарных элементов или атомов и правил если — то, выраженных в виде правил логики первого порядка. Идея логического вывода имплицитной тональности из экс-

Денг и Дж. Виби [Deng, Wiebe, 2015] использовали логические операции. Их модель определялась использованием множества элементарных элементов или атомов и правил если — то, выраженных в виде правил логики первого порядка. Идея логического вывода имплицитной тональности из экс-

плицитной является одной из удачно формализуемых идей, поскольку создание алгоритма вывода представляется возможным.

Отдельно могут составляться правила для обработки фрагментов усиления или ослабления тональности [Zhang, Liu, 2011].

Анализ тональности на протяжении последних 1 5 лет является актуальным и активно развивающимся направлением исследований, постоянно происходит улучшение подходов к анализу, внедрение новых идей и развитие старых.

Анализ тональности начал развитие с рецензий на фильмы и отзывы, но сейчас он более востребован в других сферах. Рецензии и отзывы стали хорошей основой для развития подходов, адаптации новых идей и методов. Если анализ отзывов имеет практическую значимость, то анализ рецензий для коммерческих компаний не представляет большого интереса. Актуальным направлением является анализ социальных сетей и новостных сообщений с целью выявления отношения к отдельным персонам или событиям. Это востребовано как в сфере политики, поскольку можно отслеживать отношение людей к персонам и проводимым реформам, так и в коммерческой среде. Многие крупные компании заинтересованы в системах анализа данных, с помощью которых можно отслеживать изменения в отношении пользователей к бренду или продукту.

Рецензии и отзывы стали хорошей основой для развития подходов, адаптации новых идей и методов. Если анализ отзывов имеет практическую значимость, то анализ рецензий для коммерческих компаний не представляет большого интереса. Актуальным направлением является анализ социальных сетей и новостных сообщений с целью выявления отношения к отдельным персонам или событиям. Это востребовано как в сфере политики, поскольку можно отслеживать отношение людей к персонам и проводимым реформам, так и в коммерческой среде. Многие крупные компании заинтересованы в системах анализа данных, с помощью которых можно отслеживать изменения в отношении пользователей к бренду или продукту.

Анализ тональности может являться составной частью других интеллектуальных систем, популярных в настоящее время, таких как выявление стресса у пользователей социальных сетей, определения fake news, систем извлечения данных (англ. data mining), в которых тональные отношения могут извлекаться как отдельный вид связи между объектами.

Это позволяет говорить о неутихающем интересе к анализу тональности как прикладной задаче, более того, в настоящее время его можно считать самостоятельным направлением компьютерной лингвистики с собственной терминологией и уникальными методами.

Список литературы

Адаскина Ю.В., Паничева П.В., Попов А.М. Сентиментный анализ твитов на основе синтаксических связей // Компьютерная лингвистика и интеллектуальные технологии: По материалам ежегодной Международной конференции «Диа-

лог» (Москва, 27-30 мая 2015 г.). — Москва: Изд-во РГГУ, 2015. — Вып. 14 (21): в 2 т. — Т. 2: Доклады специальных секций. — С. 1-12.

Лукашевич Н.В., Левчик А.В. Создание лексикона оценочных слов русского языка РуСентилекс // Труды конференции 0STIS-2016. — Минск: Белорусский государственный университет информатики и радиоэлектроники, 2016. — С. 377382.

Семина Т.А. Дихотомия субъективность vs объективность и тональная релевантность в задачах анализа тональности // Вестник Московского государственного областного университета. Серия Лингвистика. — Москва: Московский государственный областной университет, 2018. — № 1. — С. 38-45.

Семина Т.А. Корпусные исследования и анализ тональности // Слово. Словарь. Термин. Лексикограф [Электронный ресурс]: сборник статей по материалам Международной научно-практической конференции памяти доктора филологических наук, профессора Юрия Николаевича Марчука (г. Москва, 1-2 марта 2019) / ред. колл.: отв. ред. И.И. Валуйцева, отв. секр. Е.П. Савченко, ред. англ. текста И.А. Улиткин; под общ. ред. И.И. Валуйцевой. [Электрон. текстовые дан. (15,6 Мб)]. — Москва: ИИУ МГОУ, 2019. — С. 560-566.

A survey on the role of negation in sentiment analysis / M. Wiegand, A. Balahur, B. Roth, D. Klakow, A. Montoyo // Proceedings of the workshop on negation and speculation in natural language processing. — 2010. — P. 60-68.

Almatarneh S., Gamallo P. Searching for the most negative opinions // International Conference on Knowledge Engineering and the Semantic Web. Springer, Cham. — 2017. — P. 14-22.

Araque O., Zhu G., Iglesias C.A. A semantic similarity-based perspective of affect lexicons for sentiment analysis // Knowledge-Based Systems. — 2019. — Т. 165. -P. 346-359.

Baccianella S., EsuliA., Sebastiani F. Sentiwordnet 3.0: an enhanced lexical resource for sentiment analysis and opinion mining // Lrec. — 2010. — Т. 10, N 2010. -P. 2200-2204.

Bhatia P., Ji Y., Eisenstein J. Better document-level sentiment analysis from rst discourse parsing. — Mode of access: https://arxiv.org/pdf/1509.01599.pdf.

Chen C.C., Huang H.H., Chen H.H. NTUSD-Fin: a market sentiment dictionary for financial social media data applications // Proceedings of the 1 st Financial Narrative Processing Workshop (FNP 2018). — Mode of access: http://nlg.csie.ntu.edu.tw/~hhhuang/docs/fnp2018.pdf

Chen Y., Skiena S. Building Sentiment Lexicons for All Major Languages // ACL (2). — 2014. — P. 383-389.

Dave K., Lawrence S., Pennock D.M. Mining the peanut gallery: Opinion extraction and semantic classification of product reviews // Proceedings of the 1 2 th international conference on World Wide Web // ACM. — 2003. — P. 519-528.

Deng L., Wiebe J. Joint prediction for entity/event-level sentiment analysis using probabilistic soft logic models // Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. — 2015. — P. 179-189.

Effective Sentiment Analysis of Chinese Online Reviews with Syntax Tree and Linguistics Heuristics / C. Cai, Q. Meng, J. Ji, Z. Wang // International Journal of Advancements in Computing Technology. — 2013. — Т. 5, N 1. — P. 8-19.

Hatzivassiloglou V., McKeown K.R. Predicting the semantic orientation of adjectives // Proceedings of the 35 th annual meeting of the association for computational linguistics and eighth conference of the european chapter of the association for computational linguistics. / Association for Computational Linguistics. -1997. — P. 174-181.

Hatzivassiloglou V., Wiebe J.M. Effects of adjective orientation and gradability on sentence subjectivity // Proceedings of the 18 th conference on Computational linguistics. / Association for Computational Linguistics. -2000. — Vol. 1. — P. 299-305.

Kochergina K.S. Approaches to forming an evaluative lexicon (juridical linguistic aspect) // Актуальные проблемы лингвистики и литературоведения: сб. материалов I (XVI) Международной конференции молодых ученых (9-11 апреля 2015 г.). — Томск, 2015. — Вып. 16. — С. 365-367. — Режим доступа: http://vital.lib.tsu.ru/vital/access/manager/Repository/vtls:000534180

Kraus M., Feuerriegel S. Sentiment analysis based on rhetorical structure theory: Learning deep neural networks from discourse trees // Expert Systems with Applications. — 2019. — Т. 118. — P. 65-79.

Nasukawa T., Yi J. Sentiment analysis: Capturing favorability using natural language processing // Proceedings of the 2 nd international conference on Knowledge capture. ACM. — 2003. — P. 70-77.

Polarity analysis of texts using discourse structure / B. Heerschop, F. Goossen, A. Hogenboom [et al.] // Proceedings of the 20 th ACM international conference on Information and knowledge management. ACM. — 2011. — P. 1061-1070.

Recursive deep models for semantic compositionality over a sentiment treebank / R. Socher, A. Perelygin, J. Wu [et al.] // Proceedings of the 2013 conference on empirical methods in natural language processing. — 2013. — P. 1631-1642.

The general inquirer: A computer approach to content analysis / Stone P.J., Dunphy D.C., Smith M.S., Ogilvie D.M. — Cambridge: The MIT Press, 1966. — 651 p.

Tausczik Y.R., Pennebaker J.W. The psychological meaning of words: LIWC and computerized text analysis methods // Journal of language and social psychology. -2010. — Т. 29, N 1. — P. 24-54.

Thet T.T., Na J.C., Khoo C.S.G. Aspect-based sentiment analysis of movie reviews on discussion boards // Journal of information science. — 2010. — Т. 36. N 6. -P. 823-848.

Turney P.D. Thumbs up or thumbs down?: semantic orientation applied to unsupervised classification of reviews // Proceedings of the 40 th annual meeting on association for computational linguistics / Association for Computational Linguistics. -2002. — P. 417-424.

Wiebe J. Learning subjective adjectives from corpora // AAAI Proceedings 2000. — Mode of access: https://aaai.org/Papers/AAAI/2000/AAAI00-113.pdf

Wiebe J.M. Tracking point of view in narrative // Computational Linguistic. -Vol. 2 s.-1994. — Т. 20, N 2. — P. 233-287.

Wiebe J .M., Bruce R.F., O Hara T.P. Development and use of a gold-standard data set for subjectivity classifications // Proceedings of the 37 th annual meeting of the Association for Computational Linguistics. — 1999. — P. 246-253.

Zhang L., Liu B. Identifying noun product features that imply opinions // Proceedings of the 49 th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies: short papers / Association for Computational Linguistics. — 2011. — Vol. 2. — P. 575-580.

2020.04.009. ЛИНГВИСТИЧЕСКИЙ АНАЛИЗАТОР: ПРЕОБРАЗОВАНИЕ ТЕКСТА В МЕТАЯЗЫКОВУЮ СТРУКТУРУ ДАННЫХ / Кузнецов С.А., Скребцова Т.Г., Суворов С.Г., Клеменье-ва А.В. — Санкт-Петербург: СПбГУ, 2019. — 238 с.

Ключевые слова: автоматический перевод; автоматическая обработка текста; лингвистический анализатор; естественный язык; русский язык; метаязыковая сеть.

В пяти главах монографии (глава 1 «Графематический анализ», глава 2 «Атрибуция токенов», глава 3 «Конструктивно-синтаксический анализ предложения», глава 4 «Коммуникативно-синтаксический анализ», глава 5 «Функционально-прагматический анализ текста»), упорядоченных согласно последовательности этапов обработки текста, рассматриваются графематический анализ, морфологический (атрибуция токенов), конструктивно-синтаксический и коммуникативно-синтаксический анализ предложения, функционально-прагматический анализ текста. Продемонстрирована работа лингвистического анализатора, процесс преобразования понятийно-риторических единиц текста и информационного представления текста в метаязыковую структуру данных.

Проблема автоматической обработки естественного языка сохраняет свою актуальность по прошествии более полувека со времени первых опытов в данном направлении. Сам факт говорит о высокой сложности задачи и отсутствии ясного представления о путях ее решения.

В монографии предлагается оригинальный подход к решению задачи автоматического анализа текста, написанного на русском языке, направленный на выявление его информационной структуры. Конечным результатом анализа является метаязыковая сеть, в узлах которой находятся «участники» описываемой в тексте ситуации (объекты), а на дугах — отношения между ними. Про-

Составить текст на тему правила поведения в школе 10 предложений употребив в котором предложение не с глаголом

1. правильро

2. правильно

3. неверно

4. неверно

Мне кажется, что будет вот так:

Отрежь — отрежьте, спрячь — спрячьте, назначь — назначьте, умножь — умножьте, оставь — оставьте, намажь — намажьте, помножь — помножьте, ешь — ешьте.

Значит:

Мочь — (могите) или лучше помогите, потому, что слово «могите», у меня подчёркивают красной линией, значит ошибка, ток, что лучше напишите «помогите»!!!)))

Ветер, шумя и шелестя в березняке, перебегал в поля, покрытые белыми цветами, впитывая ароматы трав.

Циркуляция воды в озере была нарушена ,и оно зацвело .

Из-за горы и нынче видит пешеход столбы обрушенных ворот, и башни, и церковный свод. И вспомнил я отцовский дом, ущелье наше и кругом в тени рассыпанный аул. Я долго силился вздохнуть и пробудился. Удар мой верен был и скор. Он застонал, как человек, и опрокинулся. Я тайный замысел ласкал, терпел, томился и страдал. (выделенные слова однородные члены)

Введение в обработку естественного языка (NLP)

Обработка естественного языка (NLP) — это область информатики и искусственного интеллекта, связанная с взаимодействием между компьютерами и людьми на естественном языке. Конечная цель НЛП — помочь компьютерам понимать язык так же хорошо, как и мы. Это движущая сила таких вещей, как виртуальные помощники, распознавание речи, анализ тональности, автоматическое суммирование текста, машинный перевод и многое другое.В этом посте мы рассмотрим основы обработки естественного языка, погрузимся в некоторые из ее методов, а также узнаем, как НЛП помогло последним достижениям в области глубокого обучения.

Содержание

- Введение

- Почему НЛП сложно

- Синтаксический и семантический анализ

- Методы НЛП

- Глубокое обучение и НЛП

- Ссылки

I. Введение

Обработка естественного языка (НЛП) — это пересечение информатики, лингвистики и машинного обучения.Эта область фокусируется на общении между компьютерами и людьми на естественном языке, а НЛП — на том, чтобы заставить компьютеры понимать и генерировать человеческий язык. Применение методов НЛП включает голосовых помощников, таких как Amazon Alexa и Apple Siri, а также такие вещи, как машинный перевод и фильтрация текста.

NLP сильно выиграло от последних достижений в области машинного обучения, особенно от методов глубокого обучения. Поле разделено на три части:

- Распознавание речи — Перевод разговорной речи в текст.

- Natural Language Understanding — Способность компьютера понимать то, что мы говорим.

- Генерация естественного языка — Генерация естественного языка компьютером.

II. Почему НЛП сложно

Человеческий язык особенный по нескольким причинам. Он специально разработан, чтобы передать смысл говорящего / писателя. Это сложная система, хотя маленькие дети могут освоить ее довольно быстро.

Еще одна замечательная вещь в человеческом языке — это то, что все дело в символах.По словам Криса Мэннинга, профессора машинного обучения из Стэнфорда, это дискретная, символическая, категориальная сигнальная система. Это означает, что мы можем передавать одно и то же значение по-разному (например, речь, жест, знаки и т. Д.). Кодирование человеческим мозгом представляет собой непрерывный паттерн активации, посредством которого символы передаются через непрерывные звуковые и визуальные сигналы.

Понимание человеческого языка считается сложной задачей из-за ее сложности. Например, существует бесконечное количество различных способов расположить слова в предложении.Кроме того, слова могут иметь несколько значений, и для правильной интерпретации предложений необходима контекстная информация. Каждый язык более или менее уникален и неоднозначен. Достаточно взглянуть на следующий заголовок в газете «Папа папа наступает на геев». Это предложение явно имеет две очень разные интерпретации, что является довольно хорошим примером проблем в НЛП.

Обратите внимание, что идеальное понимание языка компьютером приведет к созданию ИИ, способного обрабатывать всю информацию, доступную в Интернете, что, в свою очередь, может привести к созданию общего искусственного интеллекта.

III. Синтаксический и семантический анализ

Синтаксический анализ (синтаксис) и семантический анализ (семантический) — это два основных метода, которые приводят к пониманию естественного языка. Язык — это набор правильных предложений, но что делает предложение действительным? Синтаксис и семантика.

Синтаксис — это грамматическая структура текста, а семантика — это передаваемое значение. Однако синтаксически правильное предложение не всегда является семантически правильным. Например, фраза «коровы в высшей степени текут» грамматически корректна (подлежащее — глагол — наречие), но не имеет никакого смысла.

Синтаксический анализ

Синтаксический анализ, также называемый синтаксическим анализом или синтаксическим анализом, представляет собой процесс анализа естественного языка с использованием правил формальной грамматики. Грамматические правила применяются к категориям и группам слов, а не к отдельным словам. Синтаксический анализ в основном придает тексту семантическую структуру.

Например, предложение включает подлежащее и сказуемое, где подлежащее — это существительная фраза, а предикат — глагольная фраза.Взгляните на следующее предложение: «Собака (существительная фраза) ушла (глагольная фраза)». Обратите внимание, как мы можем комбинировать каждую именную фразу с глагольной фразой. Опять же, важно повторить, что предложение может быть синтаксически правильным, но не иметь смысла.

Семантический анализ

То, как мы понимаем сказанное кем-то, — это бессознательный процесс, основанный на нашей интуиции и знаниях о самом языке. Другими словами, то, как мы понимаем язык, во многом зависит от значения и контекста.Однако к компьютерам нужен другой подход. Слово «семантический» является лингвистическим термином и означает «относящийся к значению или логике».

Семантический анализ — это процесс понимания значения и интерпретации слов, знаков и структуры предложения. Это позволяет компьютерам частично понимать естественный язык так, как это делают люди. Я говорю отчасти потому, что семантический анализ — одна из самых сложных частей НЛП, и она еще не решена полностью.

Распознавание речи, например, стало очень хорошим и работает почти безупречно, но нам все еще не хватает такого уровня знаний в понимании естественного языка.Ваш телефон в основном понимает то, что вы сказали, но часто ничего не может с этим поделать, потому что не понимает стоящего за этим смысла. Кроме того, некоторые из существующих технологий только заставляют вас думать, что они понимают значение текста. Подход, основанный на ключевых словах или статистике, или даже на чистом машинном обучении, может использовать метод сопоставления или частоты для подсказок относительно того, «о чем» текст. Эти методы ограничены, потому что они не обращают внимания на истинное значение, лежащее в основе.

IV.Методы понимания текста

Давайте рассмотрим некоторые из наиболее популярных методов, используемых при обработке естественного языка. Обратите внимание, как некоторые из них тесно взаимосвязаны и служат только в качестве подзадач для решения более крупных проблем.

Парсинг

Что такое парсинг? Согласно словарю, синтаксический анализ означает «разложить предложение на составные части и описать их синтаксические роли».

Это действительно помогло, но это могло быть немного более полным.Под синтаксическим анализом понимается формальный анализ предложения компьютером на его составные части, в результате которого создается дерево синтаксического анализа, показывающее их синтаксические отношения друг с другом в визуальной форме, которое можно использовать для дальнейшей обработки и понимания.

Ниже представлено дерево синтаксического анализа для предложения «Вор ограбил квартиру». Включено описание трех различных типов информации, передаваемых в предложении.

Буквы непосредственно над отдельными словами показывают части речи для каждого слова (существительное, глагол и определитель).Уровень выше — это некая иерархическая группировка слов во фразы. Например, «вор» — это существительное, «ограбил квартиру» — глагольное словосочетание, и, сложив вместе эти две фразы, образуют предложение, которое отмечается на один уровень выше.

Но что на самом деле означает существительное или глагольная фраза? Существительные фразы — это одно или несколько слов, которые содержат существительное и, возможно, некоторые дескрипторы, глаголы или наречия. Идея состоит в том, чтобы сгруппировать существительные со словами, которые к ним относятся.

Дерево синтаксического анализа также предоставляет нам информацию о грамматических отношениях слов из-за структуры их представления.Например, в структуре мы видим, что «вор» является субъектом «ограблен».

Под структурой я подразумеваю, что у нас есть глагол («ограблен»), который отмечен буквой «V» над ним и «VP» над ним, который связан буквой «S» с подлежащим («вор «), над которым есть» NP «. Это похоже на шаблон для отношений подлежащее-глагол, и есть много других для других типов отношений.

Стемминг

Стемминг — это метод, основанный на морфологии и поиске информации, который используется в НЛП для предварительной обработки и повышения эффективности.В словаре это определяется как «возникать или быть вызванным».

По сути, выделение основы — это процесс сокращения слов до основы слова. «Основа» — это часть слова, которая остается после удаления всех аффиксов. Например, основа слова «тронуто» — «прикоснуться». «Прикосновение» также является основой слова «прикосновение» и т. Д.

Вы можете спросить себя, зачем нам вообще нужна основа? Что ж, основа нужна, потому что мы встретимся с разными вариациями слов которые на самом деле имеют одно и то же основание и одно и то же значение.Например:

Я ехал на машине.

Я ехал в машине.

Эти два предложения означают одно и то же, и использование этого слова идентично.

А теперь представьте себе все английские слова в словаре со всеми их различными фиксациями в конце. Для их хранения потребуется огромная база данных, содержащая множество слов, которые на самом деле имеют одинаковое значение. Это решается путем сосредоточения внимания только на основе слова. Популярные алгоритмы выделения включают алгоритм вывода Портера из 1979 года, который до сих пор хорошо работает.

Сегментация текста

Сегментация текста в НЛП — это процесс преобразования текста в значимые единицы, такие как слова, предложения, различные темы, лежащее в основе намерение и многое другое. В основном текст разбивается на составляющие слова, что может быть сложной задачей в зависимости от языка. Это опять же из-за сложности человеческого языка. Например, в английском языке относительно хорошо работает разделение слов пробелами, за исключением таких слов, как «icebox», которые принадлежат друг другу, но разделены пробелом.Проблема в том, что люди иногда также пишут это как «ледяной ящик».

Распознавание именованных объектов

Распознавание именованных объектов (NER) концентрируется на определении того, какие элементы в тексте (то есть «именованные объекты») могут быть обнаружены и классифицированы по заранее определенным категориям. Эти категории могут варьироваться от имен людей, организаций и местоположений до денежных значений и процентов.

Например:

До NER: Мартин купил 300 акций SAP в 2016 году.

После NER: [Мартин] Человек купил 300 акций [SAP] организации за [2016] Время.

Извлечение отношений

Извлечение отношений берет названные объекты NER и пытается идентифицировать семантические отношения между ними. Это может означать, например, выяснение, кто с кем женат, что человек работает в определенной компании и так далее. Эта проблема также может быть преобразована в проблему классификации, и модель машинного обучения может быть обучена для каждого типа отношений.

Анализ тональности

С помощью анализа тональности мы хотим определить отношение (то есть настроение) говорящего или писателя по отношению к документу, взаимодействию или событию. Следовательно, это проблема обработки естественного языка, когда текст необходимо понимать, чтобы предсказать лежащее в основе намерение. Настроения в основном делятся на положительные, отрицательные и нейтральные категории.

С помощью анализа настроений, например, мы можем захотеть спрогнозировать мнение и отношение покупателя к продукту на основе написанного ими обзора.Анализ тональности широко применяется к обзорам, опросам, документам и многому другому.

Если вам интересно использовать некоторые из этих методов с Python, взгляните на Jupyter Notebook о наборе инструментов естественного языка Python (NLTK), который я создал. Вы также можете ознакомиться с моим сообщением в блоге о построении нейронных сетей с помощью Keras, где я обучаю нейронную сеть выполнять анализ настроений.

V. Глубокое обучение и NLP

Центральное место в глубоком обучении и естественном языке занимает «значение слова», где слово и особенно его значение представлены в виде вектора действительных чисел.С помощью этих векторов, которые представляют слова, мы помещаем слова в многомерное пространство. Интересно то, что слова, представленные векторами, будут действовать как семантическое пространство. Это просто означает, что слова, которые похожи и имеют похожее значение, имеют тенденцию группироваться вместе в этом многомерном векторном пространстве. Вы можете увидеть визуальное представление значения слова ниже:

Вы можете узнать, что означает группа сгруппированных слов, выполнив анализ главных компонентов (PCA) или уменьшение размерности с помощью T-SNE, но иногда это может вводить в заблуждение, потому что они упростите и оставьте много информации на стороне.Это хороший способ начать работу (например, логистическая или линейная регрессия в науке о данных), но он не является передовым и можно сделать это лучше.

Мы также можем думать о частях слов как о векторах, которые представляют их значение. Представьте себе слово «нежелательность». Используя морфологический подход, который включает в себя различные части слова, мы могли бы думать, что оно состоит из морфем (частей слова), например: «Un + желание + способность + ity». Каждая морфема получает свой вектор. Исходя из этого, мы можем построить нейронную сеть, которая может составить значение более крупной единицы, которая, в свою очередь, состоит из всех морфем.

Глубокое обучение также может определять структуру предложений с помощью синтаксических анализаторов. Google использует подобные методы анализа зависимостей, хотя и в более сложной и крупной манере, с их «McParseface» и «SyntaxNet».

Зная структуру предложений, мы можем начать пытаться понять смысл предложений. Мы начинаем со значения слов, являющихся векторами, но мы также можем сделать это с целыми фразами и предложениями, где значение также представлено в виде векторов.И если мы хотим знать отношения между предложениями, мы обучаем нейронную сеть принимать эти решения за нас.

Глубокое обучение также хорошо подходит для анализа настроений. Возьмем, к примеру, этот обзор фильма: «В этом фильме нет дела до ума, с каким-либо другим умным юмором». Традиционный подход попался бы в ловушку, полагая, что это положительный отзыв, потому что «сообразительность или любой другой вид умного юмора» звучит как положительное намерение, но нейронная сеть распознала бы его реальное значение.Другие приложения — это чат-боты, машинный перевод, Siri, предлагаемые ответы в папке входящих сообщений Google и т. Д.

В машинном переводе также произошли огромные успехи благодаря появлению повторяющихся нейронных сетей, о которых я также написал сообщение в блоге.

При машинном переводе, выполняемом с помощью алгоритмов глубокого обучения, язык переводится, начиная с предложения и генерируя векторные представления, которые его представляют. Затем он начинает генерировать слова на другом языке, которые влекут за собой ту же информацию.

Подводя итог, НЛП в сочетании с глубоким обучением — это все о векторах, которые представляют слова, фразы и т. Д. И до некоторой степени их значения.

VI. Ссылки

Никлас Донгес — предприниматель, технический писатель и эксперт в области искусственного интеллекта. В течение 1,5 лет он работал в команде SAP в области искусственного интеллекта, после чего основал компанию Markov Solutions. Компания из Берлина специализируется на искусственном интеллекте, машинном обучении и глубоком обучении, предлагая индивидуальные программные решения на базе искусственного интеллекта и консалтинговые программы для различных компаний.

RelatedПодробнее о Data Science

Метод анализа основной структуры второго этапа

Ассоциации компьютерной лингвистики:

Short Papers-Volume 2 (стр. 11-16). Ассоциация

компьютерной лингвистики.

Феррейра Ф., Энгельгардт П. Э. и Джонс М. В. (2009).

Достаточно хорошая языковая обработка: удовлетворительный подход

. В материалах 31-й ежегодной конференции Общества когнитивных наук.Остин:

Общество когнитивных наук.

Ямада Х. и Мацумото Ю. (2003, апрель). Statisti-

анализ зависимостей с опорным вектором ma-

скулов. В Трудах IWPT (Том 3, стр. 195-

206).

Лай, Б. Ю. Т., и Хуанг, К. (1994). Зависимость

грамматики и синтаксический анализ китайских предложений —

es. Препринт arXiv cmp-lg / 9412001.Lai, T. B.,

Huang, C., Zhou, M., Miao, J., Siu, T. K., 2001.

Анализ статистических зависимостей на основе диапазона значений Chi-

nese. В: НЛПРС. С. 677–684.

Ли, X., Zong, C., & Hu, R. (2005). Иерархический подход к синтаксическому анализу

с обработкой знаков препинания для

длинных предложений

. В материалах второй международной совместной конференции

по обработке естественного языка

: сопутствующий том, включающий

плакатов / демонстраций и отрывков из учебных пособий.

Ли З., Че В. и Лю Т. (2010, декабрь). Улучшение анализа зависимостей

с использованием знаков препинания.

Обработка азиатских языков (IALP), 2010 г. Интер-

национальная конференция (стр. 53-56). IEEE.

Сюнь Цзинь, М., Ким, М. Ю., Ким, Д., и Ли, Дж. Х.

(2004). Сегментация длинных предложений китайского

с помощью запятых. В материалах SIGHAN (стр. 1-

8).

Ковингтон М.А. (2001).Фундаментальный алгоритм

для анализа зависимостей. Материалы 39-й ежегодной юго-восточной конференции ACM

(стр. 95-102).

Нивр Дж. И Макдональд Р. Т. (2008 г., июнь). Интеграция —

на основе графиков и переходов зависимости —

cy парсеры. В ACL (стр. 950-958).

Нивр, Дж., Холл, Дж., И Нильссон, Дж. (2006 г., май). Malt-

parser: управляемый данными синтаксический анализатор-генератор для зависимого

синтаксического анализа. В трудах LREC (Vol.6. С.

2216-2219).

Нильссон, Дж., Ридель, С., и Юрет, Д. (2007, июнь). Общая задача

CoNLL 2007 по синтаксическому анализу зависимостей.

В протоколах сеанса совместной задачи CoNLL

EMNLP-CoNLL (стр. 915-932).

Нивр Дж. И Макдональд Р. Т. (2008 г., июнь). Интеграция —

на основе графиков и переходов зависимости —

cy парсеры. В ACL (стр. 950-958).

MAO, Q., LIAN, L. X., ZHOU, W.C., & YUAN, C.

F. (2007). Алгоритм синтаксического анализа китайского языка

, основанный на сегментации знаков препинания. Journal of

Chinese Information Processing, 21 (2), 3.

Sagae, K and Lavie, A. 2006a. Комбинация парсеров путем перебора

. В Proc. HLT / NAACL, страницы 129–132,

Нью-Йорк, США, июнь.

Sagae, K., & Lavie, A. (2006, июнь). Комбинация парсеров —

путём перепарсинга. InProceedings of the Human

Конференция по языковым технологиям NAACL,

Companion Volume: Short Papers (стр.129-132).

Ассоциация компьютерной лингвистики.

Ван, В. Ю., Конг, Л., Мазайтис, К., и Коэн, В.

W. (2014). Анализ зависимостей для Weibo: подход к программированию вероятностной логики Ef-

.

Ассоциация компьютерной лингвистики.

Сюэ, Н., Ся, Ф., Чиу, Ф. Д., и Палмер, М. (2005).

The Penn Chinese TreeBank: структура фраз и

обозначение большого корпуса. Инженер по естественному языку

neering, 11 (02), 207-238.

Чжоу, М. (2000, октябрь). Блочный надежный синтаксический анализатор de-

для неограниченного китайского текста.

В материалах второго семинара по китайской

языковой обработке: проводился в связи с

38-м ежегодным собранием Ассоциации ком-

предполагаемой лингвистики — Том 12 (стр. 78-84). As-

Сообщество компьютерной лингвистики.

Zhang, Y., & Nivre, J. (2011, июнь). Анализ зависимостей

на основе переходов с богатыми нелокальными функциями.

В материалах 49-го ежегодного собрания

Ассоциации компьютерной лингвистики: Человек

Языковые технологии: короткие доклады — Том

2 (стр. 188-193). Ассоциация вычислительной

лингвистики.

Дерево синтаксического анализа — обзор

Следующая грамматика демонстрирует некоторые аспекты написания DCG на Prolog. Он создает полное дерево синтаксического анализа предложения. Он обрабатывает некоторую форму согласования номеров.(Предложение вроде «Мальчик пинает мяч» будет отклонено.) Наконец, он отделяет грамматические правила от словаря. В этой форме легче поддерживать грамматику:

/ * Простая грамматика * /

предложение (s (NP, VP))

-> noun_phrase (NP, Number),

verb_phrase (VP, Number) .

существительное_фраза (np (Det, Существительное), Число) -> определитель (Det, Число),

noun (Существительное, Число).

глагольная_фраза (vp (V, NP), Number) -> глагол (V, Number, переходный), noun_phrase (NP,} _).

определитель (det (слово), число) -> [слово], {is_determiner (слово, число) |.

существительное (сущ. (Корень), Число) -> [Слово], {is_noun (Слово, Число, Корень) |.

глагол (v (Корень, Время), Число, Транзитивность) -> [Слово], {is_verb (Слово, Корень, Число, Время, Транзитивность) |.

/ * словарь * /

/ * определитель * /

is_determiner (a, единственное число).

is_determiner (каждый, в единственном числе).

is_determiner (единственное число).

is_determiner (все, множественное число).

/ * существительные * /

is_noun (мужчина, единственное число, мужчина).

is_noun (мужчины, множественное число, мужчина).

is_noun (мальчик, единственное число, мальчик).

is_noun (мальчики, множественное число, мальчик).

is_noun (женщина, единственное число, женщина).

is_noun (женское, множественное число, женщина).

is_noun (шар, единственное число, шар).

is_noun (шары, множественное число, мяч).

/ * глаголы * /

is_verb (Слово, Корень, Число, Время, Транзитивность): —

verb_form (Слово, Корень, Число, Время), инфинитив (Корень, Транзитивность).

инфинитив (удар, переходный).

инфинитив (живой, непереходный).

инфинитив (вроде, переходный).

глагол_форма (удары ногой, единственное число, присутствует).

глагол_форма (удар, удар, множественное число, присутствует).

глагол_форма (ударил, удар, _, мимо).

verb_form (живет, жить, единственное число, настоящее) .verb_form (жить, жить, множественное число, настоящее).

глагол_форма (жил, жив, _, прошлое).

verb_form (нравится, нравится, единственное число, присутствует).

verb_form (нравится, нравится, множественное число, присутствует).

verb_form (понравилось, понравилось, _, прошлое).

Эта грамматика позволяет анализировать исходное предложение «Мальчик пнул мяч», создавая следующее дерево синтаксического анализа:

Кроме того, можно анализировать множество других предложений, большинство из которых могут не иметь смысла, например

Без учителя. грамматическая индукция подъязыка клинических отчетов | Journal of Biomedical Semantics